致富信息

为啥有些方言使用人口过千万,却依然未有机翻?

现在地球上大概有七千种语言,前十种的使用者至少都是大几千万,而列表上排最后的那三四种,也就千把人还在说。

这列表的中间部分才叫千头万绪。好几百种依然有过百万的使用者,在网络上却毫无势力,“强势”语种能享受到的通达便利,它们是得不到的。举例来说:瑞典语,使用人口九百六十万,维基文章量以三百万篇列全球第三。有谷歌、必应翻译支持,脸书、Siri、油管字幕全都有默认选项;而另一边则有印度地方的奥里雅语Odia/Oriya,使用人口三千八百万,你在谷歌翻译上却是找不到的;埃塞俄比亚的奥罗摩语Oromo,使用人口三千四百万,在维基上只有772页资料。

希腊、捷克、匈牙利和瑞典等语言的使用者在网上能得到体贴的服务,而印度比哈尔语(五千万)、西非富拉语(二千四百万)、孟加拉的塞海蒂语(一千一百万)、南美盖丘亚语(九百万)等使用人口至少同样庞大的语种,在机翻界却无人问津,原因是什么?

部分原因在于希腊瑞典等地的国语是欧盟的官方语种,意味着这些国家内部自始至终,都有一批官译民工在搬译欧盟会议每年生产的海量文书。译者们经手的文件像落叶一样堆积,其结果就是相互连结的文字矿脉,用语言学家们的说法即是:平行/对照语料库parallel corpus。理论上,除了会议文书外,新闻、小说、电影台词也都是“沉积物”。目前的机翻引擎,就是靠着提取这种语料库来完成工作的,如果“niche”跟“生态位”的对应出现得足够频繁,电脑就会把这组等式往前排洗。

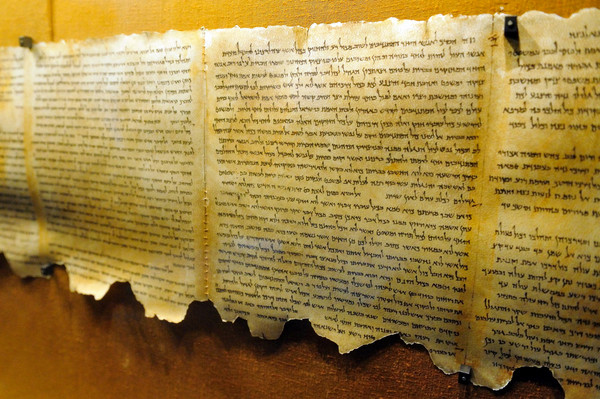

文字数据的矿脉要够深厚,才能支撑起足以让人接受的机翻。如果机器只吃官方文件,那它翻译大众流行语时表现就会很差劲。而目前的状况是,即使“强势”语种的语料库也并不够丰富:在很多西方语种里,最大块的对照语料依然是圣经,所以你往谷歌里输入些无意义的字母串时,它偶尔会刮上来一整段正经八百的末日预言。

文字库存之外,就是经济和全民学养层次带来的差异。有些百万级语种压根就未有字典,群体识字率也十分勉强,而另一边,瑞典网民里甚至有人写出个bot,自动把他们国内山林湖泊等自然景观的基本信息分类更新上维基。语料不是凭空出现的,它们需要人来创作、录入,而人需要受教育、仓廪丰实才有那个闲情心力沉下来从事文字工作,而后历数代人长年耕垒,经几国交往互通,期间有幸不受天灾人祸干扰,一国的语料库才会深厚。

弱势语种地区除了明摆着的翻译服务欠缺外,跟强势语种国家相比其实还有别的麻烦。比如某地发生地震、洪涝或瘟疫,使用强势语种的灾区接受外来援助时会顺畅得多,而弱势语种区还得先投入成本来磨合交流问题。说不定正是天灾人祸爆发频率偏比别的地方高,语种才强势不起来

2010年海地发生强烈地震,当时国际救援组织发现最急需筹备的资源之一,是通晓克里奥尔语的译者;西非的埃博拉疫情,当地工作还要特地找斯瓦希里、南德、姆布巴、克里欧、门德和泰姆尼等各族土著里会外语的人来协助。这些贫落国家和地区,既非跨国技术企业心目中的客户,当地人又大都受生活所迫,根本就没有栽培本土文化的余裕,要按传统模式积累出堪用的语料库,怕也是数十年后的事了。

要解决以上的问题有一个明显方向,就是做出一种即使脱离平行语料库也照样能产出可理解译文的翻译机。

美国国防部有个研究局(Darpa)就在考虑这样的项目,他们想开发出一种霰弹式的翻译机制:不需要详尽紧实的语料根底,而是从社交平台和传媒上搜罗片言碎语;亦没有针对的语种,而是无论输入什么语言,都只需稍加调试就能产出能懂的译文。毕竟在灾难发生的时候,我们需要的不是能翻译散文章句的神器,一般来说,单单知道山河村落的名字方位,知道失踪者性别和人数,就已经能救命了。为此,Darpa正在给好几家大学和公司的研究团队拨款,一年两次设计情景来考察这些机构的研发成果。他们测试期间产生的语料数据都会录入网络,自然也会陆续汇入Siri和谷歌等引擎的食槽。

虽然弱势语种没有一望无际的文本,也没有多少科班出身的外语译者,但几乎都已经形成了社交网络。从西非到南美,有数以千百万计的人正跟你我一样拿着手机摸鱼,用各自的方言抱怨“天气”,炫耀下午跑去玩的“地方”,摆拍晚饭“吃”什么。他们不会想到这些发完就忘的水帖里,点滴线索兴许终有一日能救死扶危。

原文:《The Widely-Spoken Languages We Still Can’t Translate Online》,有改动

本文译自 wired,由 梁兵 编辑发布。