人工智能

新算法通过观看视频发现语言

MIT博士生Mark Hamilton开发的DenseAV算法,通过音频和视频匹配学习人类语言。

MIT电气工程与计算机科学博士生Mark Hamilton,MIT计算机科学与人工智能实验室(CSAIL)成员,旨在利用机器理解动物的交流方式。为此,他首先创建了一个从零开始学习人类语言的系统。

“有趣的是,灵感来自电影《企鹅的行进》中的一幕。一只企鹅在冰上摔倒时发出一声呻吟,就像是在说脏话。这时我们想,也许我们可以用音频和视频来学习语言,”Hamilton说。“是否有可能让一个算法整天看电视,从中找出我们在说什么?”

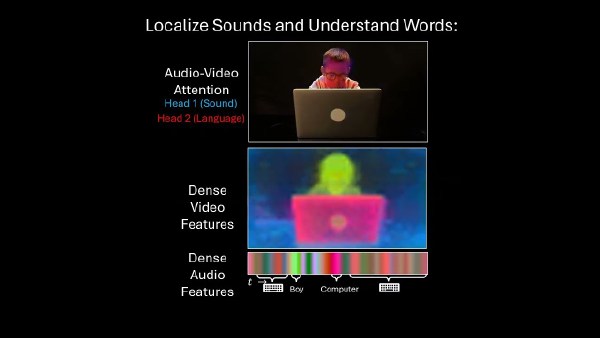

Hamilton和他的同事们训练了DenseAV模型,通过匹配音频和视频来学习语言。例如,当听到“在350度下烤蛋糕”时,模型会寻找蛋糕或烤箱的图像。在训练DenseAV时,研究人员观察了模型在听到声音时关注的像素点。例如,当有人说“狗”时,算法会立即在视频中寻找狗。这种像素选择过程可以揭示算法对词语的理解。

更有趣的是,当DenseAV听到狗叫声时,它也会在视频中寻找狗。这引起了研究团队的兴趣,他们想知道算法是否能区分“狗”这个词和狗叫声。通过给DenseAV一个“双侧大脑”,研究发现,DenseAV的一侧自然专注于语言,例如“狗”这个词,另一侧则专注于声音,如狗叫声。这表明DenseAV不仅学会了词语的含义和声音的位置,还学会了区分这些跨模态的联系,而无需人工干预或书面语言知识。

Hamilton表示,DenseAV可以应用于学习互联网上发布的大量视频内容,如教学视频。另一个令人兴奋的应用是理解没有书面形式的语言,如海豚或鲸鱼的交流。最终,研究团队希望这种方法能用于发现其他信号对之间的模式,比如地震声音和地质学之间的关系。

研究团队面临的主要挑战是无需任何文本输入学习语言。他们的目标是从零开始重新发现语言的含义,避免使用预训练的语言模型。这种方法受到儿童通过观察和倾听环境来学习语言的启发。

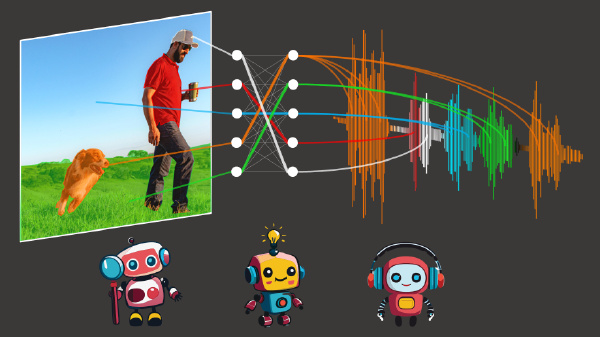

为了实现这一目标,DenseAV使用了两个主要组件分别处理音频和视频数据。这种分离使得算法无法作弊,迫使其识别物体,并为音频和视频信号创建详细而有意义的特征。DenseAV通过比较音频和视频信号对来学习哪些信号匹配,哪些信号不匹配。这种称为对比学习的方法不需要标注的例子,使DenseAV能够自行找出语言的重要预测模式。

DenseAV和以前算法的主要区别在于,以前的方法只关注声音和图像之间的单一相似性。而DenseAV算法搜索并聚合音频片段和图像像素之间的所有可能匹配。这不仅提高了性能,还允许团队精确定位声音。

研究人员在包含200万个YouTube视频的AudioSet上训练了DenseAV,并创建了新数据集来测试模型的链接声音和图像的能力。在这些测试中,DenseAV在识别对象名称和声音的任务中优于其他顶尖模型,证明了其有效性。

由于涉及的数据量巨大,项目完成耗时约一年。团队表示,转向大规模变压器架构带来了挑战,因为这些模型很容易忽视细节。

未来,团队旨在创建能够从大量视频或音频数据中学习的系统,这对于新的领域至关重要,因为这些领域可能只有大量的单一模式数据。团队还计划通过使用更大的架构,并可能整合语言模型的知识来提高性能。

“识别和分割图像中的视觉对象,以及音频记录中的环境声音和口语词汇,本身就是各自的难题。DenseAV在通过视觉和声音观察世界的过程中,同时解决这些任务方面取得了重大进展,”未参与此工作的德克萨斯大学奥斯汀分校计算机科学助理教授David Harwath说。“该模型对所说的具体语言没有任何假设,因此原则上可以从任何语言的数据中学习。通过扩展到数千或数百万小时的多种语言视频数据,看看DenseAV能学到什么,将是一件令人兴奋的事。”

论文的其他作者包括牛津大学计算机视觉工程教授Andrew Zisserman,Google AI感知研究员John R. Hershey,以及MIT电气工程与计算机科学教授、CSAIL首席研究员William T. Freeman。他们的研究得到了美国国家科学基金会、皇家学会研究教授职位和EPSRC视觉AI项目的部分支持。这项工作将在本月的IEEE/CVF计算机视觉与模式识别会议上展示。